铰链损失(Hinge Loss)是支持向量机(Support Vector Machine, SVM)中最为核心的损失函数之一。该损失函数不仅在SVM中发挥着关键作用,也被广泛应用于其他机器学习模型的训练过程中。从数学角度来看,铰链损失函数提供了一种优雅的方式来量化分类器的预测性能。

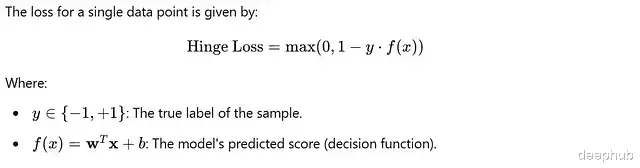

数学表达式铰链损失函数的标准数学形式为:

L(y, f(x)) = max(0, 1 - y·f(x))

其中:

y ∈ {-1, 1}:表示真实标签

f(x):表示模型的预测输出

y·f(x):表示预测值与真实标签的乘积

核心特性铰链损失函数具有以下关键特性:

凸性:函数在整个定义域上都是凸函数,这保证了优化过程能够收敛到全局最优解

非光滑性:在点y·f(x) = 1处不可导,这一特性与支持向量的概念密切相关

稀疏性:能够产生稀疏的支持向量,提高模型的泛化能力

边际最大化:通过惩罚机制促进决策边界的边际最大化

工作机制详解铰链损失函数的工作机制可以分为三种情况:

完全正确分类 (y·f(x) ≥ 1)在这种情况下:

样本被正确分类,且位于分类边际之外

损失值为0

数学表达:max(0, 1 - y·f(x)) = 0

示例计算:当y·f(x) = 1.2时max(0, 1 - 1.2) = max(0, -0.2) = 0

边际区域内的分类 (0 < y·f(x) < 1)这种情况表示:

样本分类正确,但落在分类边际内

损失值随着样本向决策边界靠近而线性增加

通过这种机制鼓励模型建立更宽的分类边际

示例计算:当y·f(x) = 0.5时max(0, 1 - 0.5) = 0.5

错误分类 (y·f(x) ≤ 0)在这种情况下:

样本被错误分类

损失值大于1,且随着预测值偏离真实标签而线性增加

这提供了强烈的梯度信号,促使模型调整参数

示例计算:当y·f(x) = -0.4时max(0, 1 - (-0.4)) = max(0, 1.4) = 1.4

实现与优化基础实现以下是铰链损失函数的基础Python实现:

import numpy as np def hinge_loss(y_true, y_pred): """ 计算铰链损失 参数: y_true: 真实标签,取值为{-1, 1} y_pred: 模型预测值 返回: 每个样本的铰链损失值 """ return np.maximum(0, 1 - y_true * y_pred) # 示例使用y_true = np.array([1, -1, 1]) y_pred = np.array([0.8, -0.5, -1.2]) loss = hinge_loss(y_true, y_pred)print("Hinge Loss:", loss)

向量化实现与优化在实际应用中,我们通常需要更高效的实现方式:

def vectorized_hinge_loss(y_true, y_pred, average=True): """ 向量化的铰链损失计算 参数: y_true: 真实标签数组,形状为(n_samples,) y_pred: 预测值数组,形状为(n_samples,) average: 是否返回平均损失 返回: 损失值或损失数组 """ losses = np.maximum(0, 1 - y_true * y_pred) return np.mean(losses) if average else losses

实际应用中的考虑因素优势边际最大化

自动寻找最优分类边际

提高模型的泛化能力

减少过拟合风险

稀疏性

产生稀疏的支持向量

提高模型的计算效率

降低存储需求

鲁棒性

对异常值不敏感

具有良好的泛化性能

适合处理线性可分问题

与其他损失函数的比较相对于对数损失铰链损失对分类边际的要求更严格

不要求概率输出

计算更简单,优化更高效

相对于0-1损失提供了连续的梯度信息

便于优化

对模型的鲁棒性要求更高

总结铰链损失函数是支持向量机中的核心组件,它通过优雅的数学形式实现了以下目标:

最大化分类边际

提供有效的优化目标

产生稀疏的解

在实际应用中,深入理解铰链损失的特性和实现细节,对于构建高效且鲁棒的分类模型至关重要。

https://avoid.overfit.cn/post/61d9c9ea96f8475f80694d42092c9d02