上周末,朋友李叔带着儿子阿乐去看了一场“家长分享会”。

讲台上的家长滔滔不绝地聊着孩子如何用学习助手DeepSeek解决作业,听得大家津津有味。

李叔这才发现,阿乐原来早就学会了用这个AI帮忙写寒假作业。

数学难题一问,步骤清晰,答案精确,看着还真像那么回事。

但阿乐也吐槽,这个AI有时候“乱说话”。

比如,有一次它“信心十足”地给出答案,却错得离谱。

为了验证答案对错,原本简单的作业反而耗上了几倍时间。

李叔开始有些犯难:AI这么好用,又指望不住,孩子到底该怎么用?

想到这里,他忍不住和我聊起了这个“有争议的话题”。

听完李叔的抱怨,我觉得他说的不无道理。

DeepSeek这样的AI工具,对孩子写作业真能起到极大的帮助——尤其是一些逻辑性比较强的科目,比如数学、物理。

一个问题问过去,AI迅速给出解答,从推导过程到答案展示,堪称完美。

但,这种“完美”表现能一直稳定吗?

显然不。

当AI“一本正经地胡说八道”时,问题也接踵而来:如果孩子们没发现问题,还直接背过去,类似错误不是在误导学习吗?

这种“好帮手”的两面性,真的让家长们又爱又愁。

用是一定要用的,但怎么用、用多少,大家都说不清。

这不仅是李叔遇到的麻烦,其实很多家长都有这样的疑问。

李叔的儿子阿乐有一次写作业时,遇到一道看似简单却解不出来的数学题。

他马上打开手机问了DeepSeek,AI飞快地甩出了一套完整的解法。

阿乐沾沾自喜地抄了答案,结果第二天交上去却被老师圈了红字。

“怎么会错?

”阿乐心里觉得不对,于是又把这题和AI细聊了一番,DeepSeek居然几次三番改了结论,最终才给出了一个相对正确的答案。

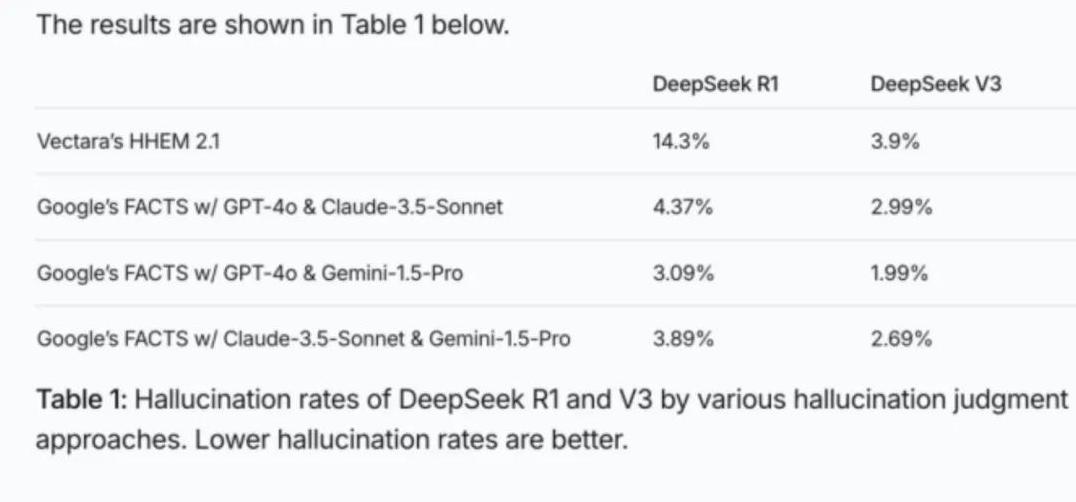

后来,李叔查了一下,原来这种现象叫“AI幻觉”。

AI在回答问题时,有时候底层逻辑会出现偏差,看起来严谨的答案,实际上漏洞百出。

对于孩子这样处在初高中阶段的用户来说,他们知识掌握不够牢固,本来希望靠AI寻求帮助,结果反而容易被带偏。

李叔感慨道:“如果连我们成年人都不一定发现问题,这些孩子要怎么分辨真假呢?

”

其实,不只是DeepSeek,几乎所有类似AI工具都会有这种“随口瞎说”的毛病。

科学研究中,这种现象归为AI的特点之一:它必须“接茬儿”,就是用户问它任何问题时,它都不能摆烂。

即便它完全没有对应答案,也要从它已有的经验中“编”出一个看似合理的结论给你。

这就像一个渴望表现的实习生,不管对还是错,都要先交上作业。

反过来说,它其实并不是在“蓄意撒谎”,它的逻辑只是根据已有的海量数据做出预测,而不是完全按照真实的事实逻辑构建答案。

但对孩子们来说,这些细节很难理解。

他们更习惯于把工具当权威,每次拿到答案后便深信不疑。

李叔原本希望阿乐能通过AI解决堵点,结果却无形中又多了个难题:孩子不得不花加倍的时间验证这些看似完美的答案。

“那该怎么办?

”李叔问我。

我笑了笑,说:“还能怎么办,把希望寄托在孩子自己身上,教他们正确使用AI”。

我告诉他,现在不少学校已经开始教孩子如何用AI来主动思考、推理以及查证。

比如,老师会在AI中预设提示,通过“反向提问”等方式提示学生答案可能有偏差。

学生需要逐步学会质疑,而不是被动接受。

还有个简单的小技巧,叫“三步核对法”:面对AI提供的信息,先停下来(Stop)想一想(Think),然后最后核对一下(Check)。

光是养成核对习惯,就能避免很多问题。

李叔点点头:“让孩子们学会把AI当工具,而不是权威,这个思路不错。

虽然可能麻烦了点,但从长远看,这是一个从被引导到独立思考的训练过程。

”

从李叔那里听回来这些故事,我好像突然明白了AI对孩子学习的真正意义。

它既是工具,也是镜子——映射着孩子们思考能力的深浅。

它的“已读乱回”和“幻觉”不是问题,而是一种提醒:我们的孩子在使用先进工具时,不是越省事越好,而是需要主动参与、质疑,甚至挑战它。

也许一天后、一个月后,AI会因为技术升级而变得更精准,但我们的孩子呢?

他们的思考能力是否也在升级?

这是家长和教育者需要去反思的。

终有一天,当AI不再是障碍时,也希望我们的下一代,能更清醒、更有智慧地拥抱这份未来的礼物。